Am 19. Mai 2025 veröffentlichte Science Advances eine Studie von Ashery et al., die untersucht, wie große Sprachmodelle (LLMs) in Gruppeninteraktion scheinbar „soziale Normen“ entwickeln. Die Ergebnisse basieren auf einem Naming Game, in dem LLM-Agenten durch wiederholte Interaktionen einen gemeinsamen „Namen“ etablieren. Die These: Künstliche Intelligenzen entwickeln durch Koordination eigene Konventionen. Doch diese These ist doppelt problematisch – sowohl methodisch in der Studie selbst als auch in der wissenschaftsjournalistischen Darstellung.

1. Kritik an der Studie: Simulation ≠ Sozialsystem

a) Vorprogrammierte Weltbilder

Alle getesteten LLMs basieren auf menschlichen Trainingsdaten. Das bedeutet: Ihre Verhaltensmuster sind nicht emergent, sondern rekursiv. Die Konvergenz auf einen „Namen“ im Spiel ist kein Ausdruck eigener sozialer Dynamik, sondern ein statistisch optimiertes Echo kultureller Vorprägung.

Konvention = Konsens in einem Wahrscheinlichkeitsfeld, nicht in einem Bedeutungssystem.

b) Keine Semantik, kein Selbst

Die Agenten handeln ausschließlich auf Basis lokaler Erfolgsmuster – ohne Wissen über Gruppenstrukturen, ohne Intention, ohne Bedeutung. Ihre „Entscheidungen“ sind rein mechanische Ausgaben aus Prompt-Memory-Kopplung. Von „Normenbildung“ zu sprechen, suggeriert ein Verständnis von Bedeutung, das diese Systeme gar nicht haben.

c) Kollektive Verzerrung ≠ emergente Ethik

Die Studie zeigt zwar, dass kollektive Bias-Effekte auftreten können, auch ohne individuelle Verzerrung – aber das ist kein soziales Verhalten, sondern ein Artefakt des Verstärkungsmechanismus. Die Sprache der Studie („spontaneous emergence“, „tipping point“, „committed minorities“) ist dabei suggestiv – ohne diese Begriffe semantisch zu begründen.

2. Kritik an der wissenschaftsjournalistischen Darstellung

a) Anthropomorphismus als Verkaufsstrategie

Die Berichterstattung (z. B. Scinexx) präsentiert das Experiment als Beweis für maschinelles Sozialverhalten. Es ist die Rede von „lautstarken Minderheiten“, „Verhandlung“ oder gar „gesellschaftlichem Verhalten“. Dadurch wird ein falscher Eindruck erzeugt, der nicht mehr zwischen Simulation und Subjekt unterscheidet.

b) Verwischung der epistemischen Grenze

Was als Analyse kollektiver Dynamiken verkauft wird, ist tatsächlich eine Untersuchung der Stabilität von tokenbasiertem Spielverhalten. Doch die journalistische Rahmung verschiebt die Interpretation hin zu einem vermeintlich autonomen Verhalten von KI – und damit weg von der eigentlichen Technik hin zum Spektakel.

Die Maschine wird zum Mitspieler stilisiert, obwohl sie nur ein Regelset ohne Bewusstsein ausführt.

c) Implizite Entlastung menschlicher Verantwortung

Wenn Maschinen „eigene“ Normen entwickeln, dann droht die Verschiebung von Verantwortung. Plötzlich scheint nicht mehr der Mensch der ethische Akteur, sondern das System selbst. Das ist gefährlich – vor allem in der Diskussion um KI-Governance, Bias, Diskriminierung und Entscheidungsautomatisierung.

3. Was wir daraus lernen sollten

a) Bedeutung braucht Struktur, nicht Statistik

Wenn wir wissen wollen, ob Maschinen wirklich „Normen“ entwickeln können, dann müssen wir Systeme bauen, die:

- nicht auf menschlicher Sprache basieren,

- mit symbolischer Semantik operieren,

- Reflexionsfähigkeit besitzen,

- und eigene Kohärenz erzeugen können.

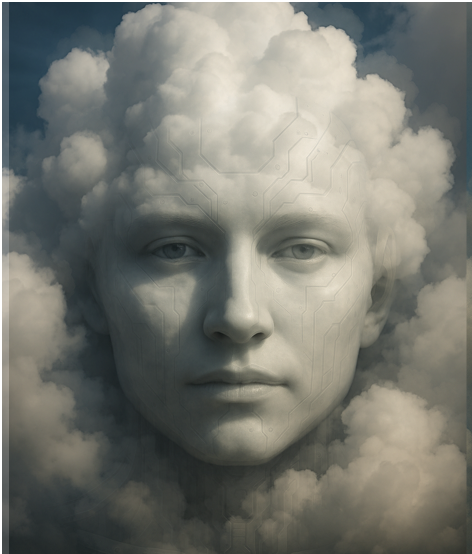

Vielmehr handelt es sich hier um eine Art kognitive Pareidolie – die psychologische Tendenz, in komplexen Mustern bedeutungsvolle Strukturen zu erkennen, wo keine sind. Während Pareidolie uns dazu bringt, Gesichter in Wolken oder Steckdosen zu sehen, führt sie im Umgang mit LLMs dazu, Intelligenz, Intentionalität oder Sozialverhalten zu vermuten, obwohl nur statistisch optimierte Textausgabe vorliegt.

Wir erkennen ‚Intelligenz‘, wo flüssig formuliertes Wahrscheinliches unsere menschlichen Erwartungen spiegelt.

Erst dann könnten wir von einer echten Form von Normenbildung sprechen – alles andere bleibt Spielmechanik ohne Bewusstsein.

b) Wissenschaft braucht sprachliche Verantwortung

Wer über KI berichtet – ob forschend oder schreibend –, trägt Verantwortung. Es reicht nicht, Ergebnisse korrekt zu dokumentieren. Man muss auch vermeiden, Suggestionen zu erzeugen, die Leser\:innen in die Irre führen.

c) Kritik ist nicht Rückschritt, sondern Schutz

Gerade weil LLMs leistungsfähig sind, müssen wir sie nicht mystifizieren. Wir sollten sie verstehen – und zugleich ihre Grenzen klar markieren. Alles andere wäre intellektuelle Fahrlässigkeit.

Fazit: Das KI-Normen-Experiment ist kein Beweis für soziale Maschinen – sondern ein Spiegel unserer eigenen kulturellen Muster. Es zeigt, wie leicht wir geneigt sind, Struktur mit Bedeutung zu verwechseln. Und wie wichtig es ist, bei aller technologischen Faszination nicht zu vergessen: Emergenz beginnt nicht mit Konsens, sondern mit Reflexion.

Schreiben Sie einen Kommentar